原创 中国考试 中国考试 2025年09月24日 14:44 北京

引用格式:李峰, 郭嘉悦, 胡新雨, 等. 大语言模型辅助情境化命题模式探索: 以创造性思维测评为例[J]. 中国考试, 2025(9): 76-86.

作 者

李 峰,北京师范大学人文和社会科学高等研究院、中国基础教育质量监测协同创新中心副教授。

郭嘉悦,北京师范大学统计学院在读硕士生。

胡新雨,北京师范大学统计学院在读硕士生。

张佳慧,北京师范大学中国基础教育质量监测协同创新中心副教授(通信作者)。

摘 要:随着大语言模型在教育领域中的广泛应用,如何利用其提升命题质量和效率已成为重要课题。本研究基于PISA 2022创造性思维测评框架,聚焦科学问题解决,探索利用大语言模型辅助生成情境化任务的技术路径。研究以781篇科普文章为材料,采用篇章映射技术与提示词工程,调用大语言模型生成题目,并经人工筛选与修订后组织实施测验。对于1156份学生作答数据和17份出声思考记录的检验分析显示,题目具有良好的区分度、拟合度与内部效度。研究表明,大语言模型可有效提升情境化命题效率,但其生成的题目仍需依赖人工审校与优化。研究结果可为区域素养测评和过程性评价中的自动化命题提供技术参考。

关键词:创造性思维;大语言模型;情境化命题;简答题

2020年5月,OpenAI发布了GPT-3,参数量达到1750亿,成为当时使用规模最大的语言模型,并在零样本学习任务上取得了突破。大语言模型(Large Language Models)从此进入快速发展和广泛应用阶段,并随着ChatGPT的推出进一步普及。大语言模型的快速进展为教育测评带来了新的可能性,已有不少研究验证了大语言模型在编程、线性代数、英语、医学、网络安全、阅读理解测验开发中的潜力。

作为驱动科技创新和社会发展的关键能力,创造性思维(creative thinking)已成为全球教育改革与质量评价的关注焦点。我国教育部印发的《义务教育课程方案和课程标准(2022年版)》及《普通高中课程方案和语文等学科课程标准(2017年版2020年修订)》均强调要提高学生的创新意识与创新精神[1-2]。国际教育评估领域近年来同样重视创造性思维的测量与比较,PISA 2022首次将15岁学生的创造性思维能力纳入评估范畴,提出结合真实或具体问题情境的“小创造力”(little-creativity)测量,关注学生在日常生活和学习中的创造性表现,评估其在真实或具体问题情境中的创造性反应[3]。

本研究聚焦PISA 2022创造性思维测评框架中的科学问题解决领域,以青少年科普杂志为材料来源,采用篇章映射(passage mapping)技术,使用大语言模型辅助生成创造性思维测评的情境化试题。在此基础上,通过分析真实的学生作答数据和出声思考资料,评估试题质量,从而探讨大语言模型辅助命题在创造性思维测评和情境化题目开发中的技术路径。

一、研究背景

(一)大语言模型辅助命题的进展

目前,大语言模型辅助命题已在多个学科领域取得积极进展。通用模型如GPT-3.5、GPT-4、ChatGPT与Bard(谷歌开发的对话式AI助手,现名为 Gemini)等在题目与测量目标的契合度、语言表达质量、认知层级覆盖、题目区分度等方面表现突出。不少研究认为其生成的题目与学习目标匹配度较高,但在相关性指标上略低于人工命题[4]。GPT-4与GPT-3.5在语言流畅性、逻辑通顺与语法正确性方面优于人工命题,尤其在计算机教育与阅读理解中表现明显[5-6]。虽然大语言模型命制的题目可涵盖理解、应用、创造等多个认知层级,但部分题目存在效度问题[7]。在医学教育、数学与阅读理解等多个领域,其生成的题目有较好的区分度[8-9],但涉及逻辑验证任务时,部分存在错误[10]。不同领域的研究者根据不同学科的知识特点与命题需求,探索了大语言模型辅助命题的路径和效果。其中,数学与科学教育、阅读理解以及医学教育是当前研究较为集中的三个领域。

在数学与科学教育领域,大语言模型能够较好地生成不同认知层级的题目,并在语言质量与干扰项设计方面优于人工命题,但在逻辑推理与程序执行类任务中仍存在不足。有研究基于教科书内容摘要,使用ChatGPT生成数学测试题,结果显示其测量学指标与教材原题基本相当,在中等难度题目的区分度方面甚至略优于原题[11]。在科学教育中,有研究发现GPT-3.5能够生成化学和生物学的高阶思维问题,其中涉及布鲁姆分类法中“评价”层级的题目表现尤为良好,题目复杂性与人工命题结果基本一致[12]。在计算机教育中,有研究依据Python课程模块与学习目标,使用GPT-4自动生成651多选题,与449道人工命题相比,在语言清晰度、正确答案唯一性和高质量干扰项编制方面均表现更佳,且题目内容与246个学习目标一致[5]。然而,在涉及程序执行逻辑验证的题目中约有三分之一题目存在逻辑性错误[10]。

阅读理解命题是大语言模型应用的另一个重要场景。多项研究表明,大语言模型能够生成覆盖多个认知层级的阅读理解题目,具备一定的区分度和信度;而通过模型微调(fine-tuning),可显著提升其在专业领域题目生成的质量与技能分布合理性。例如,有研究基于学院托福考试项目(TOEFL Institutional Testing Program)的三篇阅读理解文章,使用GPT-3.5生成了30道选择题,题目覆盖从分析到创造等多个认知层次,信度达到中等水平,但仅有三分之一的题目符合效度要求[7]。另一项针对1607名八年级学生作答数据的测量学分析显示,GPT-3.5生成的阅读理解题目具有良好的区分度,干扰项设计有效[9]。在探索从文本数据中生成问题的最佳方法时,有研究选取斯坦福问答数据集(Stanford Question Answering Dataset),分别对 distilBERT(Distilled Bidirectional Encoder Representations from Transformers)与LLaMA(Large Language Model MetaAI)模型进行微调,结果表明生成题目与基线题目的平均相似度超过60%,其中有30%的问题相似度达到70%[13]。在大学英语六级(CET-6)阅读理解题生成任务中,经过微调的模型在微技能分布、信度和拟合度方面接近人工命制的真题[14]。此外,在简答题生成方面,未经微调的BERT适用于通用型阅读理解题目,而微调后的BERT在生成专业性质题目时表现更好[15]。

在医学教育领域,大语言模型能够明显提升命题效率,生成的题目区分度普遍较高,但也存在个别选择题干扰项质量不高以及相关性指标有待提高的问题。例如,有研究基于高血压案例,利用ChatGPT生成了10道选择题,经专家评审后,其中两道题目被直接用于99名四年级医学生的考试,虽然个别干扰项质量有限,但仍表现出较高的区分度[8]。在循证医学领域,有研究使用ChatGPT生成15道题目,其中6道区分度达到可接受水平,研究者还利用OpenAI的GPT Builder平台,实现了基于学习目标的高度自动化命题,教师可快速生成基于临床案例的多选题[16]。还有研究基于本科医学教材,在医学研究生入学考试中利用ChatGPT在20分钟25秒内生成50道题,仅为人工用时的十分之一,除相关性略低外,其余指标表现良好[17]。

综上所述,从技术路径看,基于大语言模型的辅助命题主要包括两类。一类以提示词工程为核心,通常结合教材内容、学习目标或具体学科案例进行命题。为减少模型“幻觉”问题,此类方法多采用教材摘要、课程模块或阅读材料作为输入,通过大语言模型生成涵盖不同认知层级的选择题与简答题,在适切性、语言清晰度和区分度等方面表现良好。另一类是在完成预训练的大语言模型基础上,引入领域数据进行微调,以提升模型在专业知识掌握、术语理解和学科特异性逻辑推理等方面的能力。经过微调的模型在生成阅读理解简答题、专业性学科测试等任务中表现优于未微调模型,并与基准题目具有较高相似度。

(二)情境化命题

美国教育评价专家Wiggins最早提出真实性评估(authentic assessment)概念。他批评当时对标准化测试的使用方式过于片面且评价指标单一,认为尽管标准化测试具有效率优势,但真正的评估应当切实考查能力,这需要模拟真实情境中的挑战并完成典型任务,唯有如此才能促进学生的终身学习,并确保国家在教育方面取得进步[18-19]。

真实性评估包括场景化评估(scenario-based assessment,SBA)和情境化任务(contextualized tasks)两种常见形式。SBA强调真实情境中的复杂问题解决,典型应用包括医学领域的病人访谈与咨询模拟、商业领域的视觉海报制作、法律领域的客户会议准备及案件处理等[20],PISA的合作问题解决类测验较为接近SBA。情境化任务是在引入简化后的真实情境、相关材料及学科信息的同时,力求保留其核心特征的真实性。相较于SBA,情境化任务更侧重于在真实性和操作性之间取得平衡,PISA的阅读和创造性思维测验更接近情境化任务。真实性是情境化任务设计的关键。Cumming和Maxwell指出,若情境设计仅看似真实或刻板模拟,反而可能导致任务脱离实际应用情境,进而损害测评效度[19,21]。Constantinou通过分析英国应用数学(Functional Mathematics)考试中的527道情境化题目,提出强化真实性的四个原则:1)深度情境化,即将所有问题嵌入连贯的叙事背景中;2)情境平衡,即确保情境与课程目标一致;3)情境不可预测性,即避免模式化和可预测的情境设置;4)情境目的性,即确保情境对学生具有实际意义,而非仅表面关联[20]。

真实性是情境化任务设计的主要挑战之一。Tout和Spithill在总结PISA数学素养题目开发面临的挑战时指出,其核心难点在于寻找真实可信且能够被全球15岁学生理解并引发兴趣的数学情境。在命题实践中,情境化题目开发的一种常用方法是从现实生活情境入手,将其发展为完整的测试单元。然而,真实情境往往较为复杂,其中涉及的数学公式、数量信息及计算过程并不适合学生在考试环境中处理。此外,筛选和改编真实情境与任务需要投入大量的人力和时间成本[22]。另一种常用方法则是从特定数学概念或内容领域入手,尝试将其嵌入真实的任务背景中。然而,这种方法容易出现传统的课程式文字题,与现实世界的关联性与真实性不足。Tout和Spithill指出,尽管许多国家提交给PISA的题目倾向于采用后一种方法,但这类题目却很少在PISA的正式调查中被采用[23]。

从现实生活情境入手发展完整测试单元时,需要采取多种措施确保任务的情境化质量。PISA数学素养命题的实践经验表明,情境材料的审查应重点关注情境的真实性程度、阅读量的合理性、语言表述的清晰简洁、情境内容对目标群体的适切性与相关性、题干对材料核心信息的聚焦程度[23]。此外,PISA命题人员还广泛采用视觉辅助材料(如插图、图表与照片等),以降低阅读负担,增强任务的真实感受,提升学生对试题的参与度和兴趣[23]。

(三)创造性思维的概念与测评

创造力测评通常采用最佳表现测验,侧重考查个体的潜能上限。其代表性工具是托兰斯创造性思维测验(Torrance Tests of Creative Thinking),被广泛应用于测量发散思维的流畅性、灵活性、独创性和精细性[24]。我国已开发出多种本土化的测验工具,如《中学生创造性思维能力自评量表》和《中学生创造性思维量表》等[25-26]。这类测验题目相对固定,如发散思维测验可能要求“将四个图形组合成有意义的新图形”,而聚合思维测验则可能要求“找出每一题中与前面四个词或者三个词都有联系的一个词语”等[25]。

与此不同,PISA 2022将创造性思维设为独立评估领域,延续其素养导向的测评理念,强调在真实情境中生成并应用创意,将创造性思维定义为“能有效生成、评估和改进想法,以提出有创意和有实效的解决方案、知识产出或表达”的能力[3]。从创造过程的角度构建了产生多样化想法、形成创意、评估与改进想法三个维度,并基于此开发了书面表达、视觉表达、科学问题解决和社会问题解决四个领域的测试题目。

以PISA官方发布的样题“未来自行车”为例,该题目由三个任务构成,围绕15岁学生所熟悉的真实日常生活场景展开,通过多样化想法—形成创意—评估改进的任务序列,引导学生经历相对完整的创造性思维过程,考查学生改良自行车结构、优化防盗功能等日常生活中所需要的实用性创新能力;其评分主要关注学生能否提出具有新意且符合实际情境的解决方案[27]。

比较而言,传统创造力测验的题目固定、便于操作,但在任务真实性与外部效度方面存在局限;PISA创造性思维测评突出素养导向,在贴近学生生活和学习的情境中考查创意生成与应用能力,强调创造过程、实际意义与真实情境,但对命题人员要求较高,题目开发难度较大。

二、研究过程与方法

总体而言,现有研究已初步验证了大语言模型在多个学科领域辅助命题的可行性,并显示出其在提升命题效率、覆盖认知层级和生成语言质量方面的优势。然而,相关研究多集中于客观题或结构化任务,针对素养导向的简答题,尤其是创造性思维测评的命题研究仍相对匮乏。情境化命题虽强调任务真实性以及学生相关性,但情境材料的筛选仍高度依赖于人工判断,存在效率低、主观性强等问题,尚未形成可复制的高效流程。鉴于此,本研究尝试将篇章映射技术与大语言模型生成能力相结合,以创造性思维测评为应用场景,按照命题材料准备、试题生成与修订、施测与数据采集、结果分析的研究流程,从命题技术路径与测评质量检验两个方面开展探索。

(一) 题目命制

1.测评框架

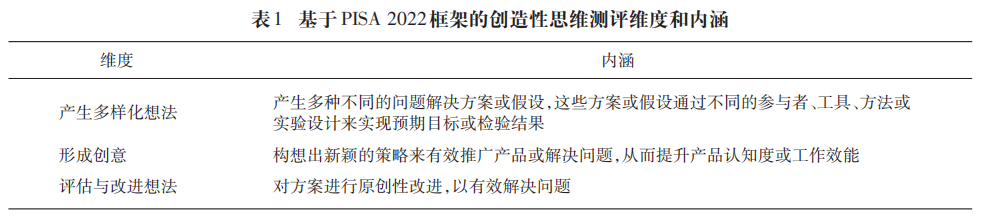

以PISA2022创造性思维测评框架为蓝本,结合八年级学生认知特点形成反映创造性思维过程的三维测评框架,见表1。

2.材料收集

科学问题解决涉及产生新见解、设计实验探索假设以及开发新方法。在本研究中,学生需针对一个开放性问题生成多个不同想法或解决方案,或提出一个原创性想法[3]。为确保情境材料的真实性与科学相关性,本研究选取知名青少年科普杂志《万物》(How It Works 中文版)作为素材来源。该杂志内容丰富、表达生动,覆盖环境生态、工程机械、太空探索、物理化学、生物医学等多个领域。研究采用该杂志2016年1月至2024年8月间出版的104期共781篇文章作为情境材料。

3.篇章映射

为评估情境材料是否适合考查创造性思维,本研究借鉴了阅读理解测验开发中的篇章映射技术。该技术通过结构化分析文本、识别关键信息及其逻辑关联,可评估篇章适配性、提取重要信息及其组织方式,并为题目开发提供建议[28-29]。在此基础上,研究通过Python3编程调用阿里云通义千问大模型Qwen2.5API(max_tokens=4096,temperature=0.2),以提示词对781篇材料进行遍历。具体而言,要求大模型针对每篇材料,依据其是否适合命制实验室发明创造、基于观察的假设生成、工程问题解决、数学与数据分析等方面的创造性思维题目[5],生成三个独特且新颖的小题命题内容;若材料不适合,则返回“无”。

4.材料审查

调用Qwen2.5API(max_tokens=4096,temperature=0.2)对情境材料进行审查,评估其内容完整性(是否提供每道题目命制所需的全部信息)和情境适切性(是否贴近我国八年级学生熟悉的生活、学习、社会、科学场景)。随后,将篇章映射的结果和情境审查的结果进行系统整理,最终筛选出17篇材料,均满足三道小题具备命题内容、信息完整且情境适切的要求,可用于后续命题开发。

5.题目生成

由于缺少可用于微调的创造性思维样题,本研究按照“目标—要求—返回格式—警告”的体例设计提示词进行命题。编程调用GPT-4o、Qwen2.5、DeepSeek-R1和Grok-3四种在文本生成、长链条推理方面表现良好的大语言模型(max_tokens=4096,temperature=0.6),要求其根据篇章映射标定的命题内容,针对每篇材料从产生多样化想法、形成创意、评估和改进想法三个维度命题。四种大语言模型共用时26分钟,生成68道各含三道小题的题目,每个题目含题干、小题、答案及解析、考查内容、考查能力等,字数在1000~1500字之间。

6. 题目筛选与修改

尽管命题所用材料均为科普类文章,且已通过大语言模型进行情境适切性筛选,但部分材料及相应题目仍存在知识结构超出八年级学生认知水平、情境远离学生日常生活或不适于进行创造性思维题目开发等问题。因此,需要对17篇材料及相应题目进行人工审题。具体来说,由课题组人员基于知识结构匹配度,排除9篇材料及相应题目,如涉及热感技术的喷墨打印机、涉及空气动力学的滑翔机飞行等;基于生活贴近度,排除3篇材料及相应题目,包括介绍土耳其加泰土丘早期人类聚落遗址、机械表内部结构和迪士尼特技机器人;基于创造性思维考查适配度,排除介绍插头基本结构的1篇材料及相应题目。

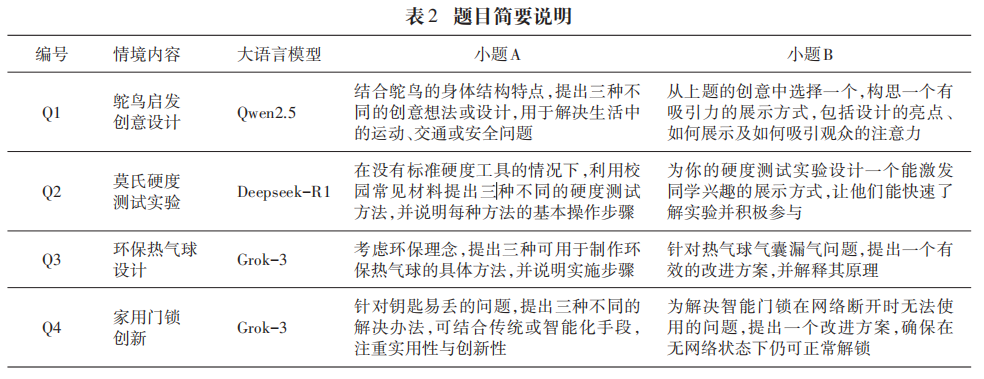

筛选后,共保留《钥匙怎么开门》《热气球》《鸵鸟的构造》《怎样测量硬度》4篇材料及相应题目,继续从情境设定是否贴近学生生活、是否考查与科学问题解决相关的创造性思维等角度进行综合分析。以《鸵鸟的构造》为例,各个大模型生成的题目侧重点不同。例如,GPT-4o命题将情境设定于北方动物园,可能会导致南方学生的参与感和熟悉感不足;Grok-3将任务置于科普展览中,要求学生布置鸵鸟展区并通过三种方式展示鸵鸟的结构与功能,强调创造性思维中的视觉表达而非科学问题解决;DeepSeek-R1聚焦观察鸵鸟的骨骼模型,要求学生对鸵鸟的高速奔跑提出三种解释性假设,并进行科学推理,体现了科学探究的特点,但更贴近科学素养而非创造性思维;Qwen2.5要求学生根据鸵鸟构造提出三种能够解决日常生活中运动、交通等问题的创造性设计,题目贴近生活,可有效考查创造性思维中的科学问题解决。综合比较,在情境贴近度、与测量目标的匹配度等方面,Qwen2.5生成的题目略胜一筹,被最终采纳。按照上述原则,本研究对四个大语言模型基于4篇材料生成的题目进行了系统分析和比较,各篇材料最终采纳的题目及所属大语言模型情况见表2。

鉴于实际测试的时间限制,对4道题目(分别标注为Q1、Q2、Q3、Q4)下的小题进行了删减,每道题目仅保留2个小题。Q1和Q2的两个小题分别考查产生多样化想法和形成创意;Q3和Q4的两个小题分别考查产生多样化想法和评估与改进想法。同时,针对部分题目补充了必要的背景信息。例如,在Q1中补充了鸵鸟的生理结构信息,在Q2 中补充了莫氏硬度的知识。各题目简要说明见表2。

7.题目配图

为降低学生阅读负担、增强任务真实感,本研究参考PISA使用插图、图表与照片等视觉形式的经验[23],根据题干内容,加入配图帮助学生理解题目。为贴近教材或杂志的配图风格,在Gemini 2.0 Flash的对话窗口中输入图形信息和线稿风格图片的要求,生成配图后插入题目,形成正式试题。

(二) 题目测试与数据采集

为缩短测试时间并减少对学校教学秩序的影响,研究采用分组测试。学校一的学生完成测验一(Q1、Q2两个题目),学校二的学生完成测验二(Q3、Q4两个题目),单次测试时间控制在15分钟以内。测试在北京市某区两所教学质量中上等的学校八年级学生中进行,采用纸笔形式,以班级为单位施测。测试前,主试向参测学生详细说明测试目的、时间安排和作答要求,鼓励学生独立思考并尽可能多地完成题目,同时强调禁止在测试中进行任何形式的讨论交流。为了解学生的创造性思维过程,研究采用出声思维法补充收集数据,即在测试结束后,主试在每个班级随机选取2~3名学生进行结构化访谈,引导其回溯并阐述思考过程。所有访谈均在受访学生知情同意后进行录音。

(三) 数据分析

测试共回收有效试卷1156份,测验一为597份,测验二为559份。测验题目均为简答题,采用多级评分体系进行评分设计。分别从测验一和测验二中随机抽取约50份答卷进行预评分,以Q1A为例,该题要求学生基于鸵鸟的特征提出三项创意设计。依据创意的数量、可行性及其与鸵鸟特征之间的关联度,对22类学生答案进行归类整理,最终形成7个计分等级的评分方案。类似地,基于作答的完整性、合理性、数量及创新性,为其他题目分别制定了3~8点计分等级的评分方案。对全部1156份试卷正式赋分后,对频数极低或经验项目特征曲线(empirical item characteristic curve)几乎重合的计分等级进行合并与重编码,Q1A合并为3级计分,其余各题也被调整为3~5级不等的计分等级。

所有题目评分等级范围在0~4级之间,其中Q2A为0~4级计分,Q4A为0~3级计分,其余题目均为0~2级计分。0分对应未作答、答非所问或内容无效;1分表示作答内容初步相关但存在不完整或不合理之处;2分反映作答基本完整且具有一定合理性;3分要求内容较为丰富、合理且覆盖多项要素;4分表示作答内容非常完整、条目丰富,且具备明显的可行性和规范性。

将学生作答数据按计分结果整理为表格,采用经典测验理论(Classical Test Theory, CTT)与项目反应理论(Item Response Theory, IRT)对测验一与测验二分别进行题目难度、区分度、单维性、项目参数和拟合度分析。所有分析均以R4.4.3完成,主要使用psych、bruceR与mirt等R包进行。

对收集的17份出声思考访谈录音进行文字转录与内容整理,围绕命题是否有效测量创造性思维进行分析。首先,对原始语料进行清洗,删除口语化的填充词(如“啊”“嗯”等),剔除重复和无关语句,统一表达风格;其次,逐一提取学生思考内容中的语句片段;最后,根据题目所对应的测评维度,从产生多样化想法、形成创意、评估与改进想法三个方面对语句片段进行标注与分类。

三、研究结果

(一)基于CTT的数据统计

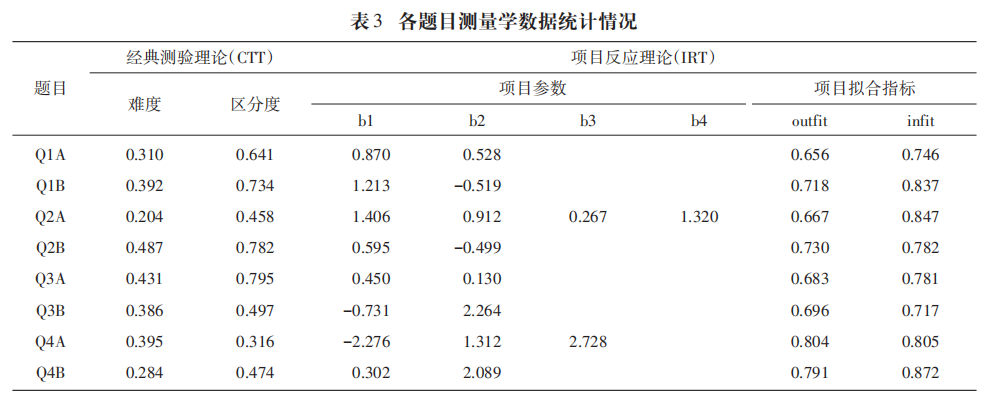

表3详细展示了所有题目的测量学指标。测验一题目难度在0.204~0.487之间,整体难度偏大。按总分将学生进行高低分组,分别计算两组在各题目上的平均得分,取得分差值并除以该题满分,得到区分度指数。测验一各题区分度均超过0.4,其中Q1B、Q2B区分度超过0.7。测验二题目难度在0.284~0.431之间,区分度均超过0.3,其中Q3A接近0.8。

(二)单维性检验

对测验一进行探索性因子分析,KMO值为0.588,接近可接受水平;Bartlett球形度检验显著(χ²= 353.32,p<0.001)。第一因子特征根为1.896,方差解释比为47.4%。测验二的KMO值为0.671,超过可接受水平;Bartlett检验显著(χ² =260.65,p<0.001),第一因子特征根为1.891,方差解释比为47.3%。尽管题目数量限制单维度检验中特征根比值法的使用,但根据两个测验中第一因子方差解释比接近50%判断,第一特征根均居主导作用,符合IRT单维性假设。

(三)基于IRT的分析

对测验一和测验二分别采用R的mirt包构建分步计分模型(partial credit model),进行参数估计。结果显示,大部分题目能够有效反映学生能力差异,Q3B、Q4A、Q4B的难度参数覆盖广泛能力区间,但也存在部分题目参数间隔较小、计分等级高而难度低的情况(如Q1B、Q2B)。以加权的残差均方(infit mean square)为拟合指标,测验一和测验二中各题目的项目拟合统计值infit值分别在0.746~0.847和0.717~0.872之间,均接近或符合infit取值应在[0.75,1.25]之内的拟合标准[30]。测验一和测验二的测验信息量峰值均在θ=0.8附近,学生能力分布的峰值均在0.2~0.3之间,基本对称,但测验一学生能力分布左侧出现了一个明显的次峰,整体呈轻度左偏趋势。

(四) 出声思考的分析

在产生多样化想法方面,参加测验一访谈的11位学生中,有4位能在Q1A中提出三种想法或设计,2位提出两种,3位提出一种,另有2位未能提出有效想法;所有学生均能够说明自己的想法如何受到鸵鸟特征的启发。对于题目Q2A,有3位学生能提出三种方案,2位提出两种方案,5位提出一种方案,1位未明确提出方案。参加测验二访谈的7位学生中,2位在Q3A中提出三种方案,4位提出一种方案,1位未作答。在题目Q4A中,有4位学生能提出三种方案,1位提出两种方案,1位提出一种方案,1位未作答。整体来看,大多数学生能够围绕题目情境提出两种及以上不同构想,表现出一定的发散性思维能力。

在产生创意方面,访谈数据显示,参加测验一的11位学生中,有9位能在Q1B中提出与日常生活经验紧密相关的创意展示方式,如演讲、体验式介绍等,2位未作答。Q2B中,有10位学生提出了创意展示方式,包括PPT、实验演示等,1位未作答。这表明大多数学生不仅能够提出创意,还能说明其展示方式的具体操作流程。

在评估与改进想法方面,测验二的7位学生中,有5位在Q3B中提出了与题目高度相关的改进方案,主要聚焦气囊泄漏问题进行分析,并结合物理知识说明改进步骤,2位未作答。Q4B中,7位学生中有6位提出了智能门锁的改进方案,涉及近场通信(Near Field Communication)、脱网唤醒等技术,1位未作答。整体而言,多数学生能够基于已有经验提出针对性强、具可操作性的优化建议。

四、结论与讨论

本研究在篇章映射技术筛选的科普材料基础上,进一步开展系统性审查,依托大语言模型生成测评题目,并通过多轮筛选与人工修订,持续优化题目质量。随后,采集学生的作答数据与出声思考记录,运用经典测验理论与项目反应理论对数据进行深入分析与检验。研究涵盖材料准备、题目生成与修订、测试实施及数据分析等关键环节,系统探讨了大语言模型在辅助创造性思维情境化命题中的应用潜力与现实挑战。具体研究发现主要包括以下四个方面。

第一,大语言模型辅助生成的题目展现出良好的区分度。测量学分析初步验证了大语言模型辅助命题的效果。从CTT角度看,多数题目区分度较高,和已有研究结果一致[9,11,16],但学生整体得分偏低,反映出题目难度较大,这可能与其不熟悉任务内容有关。在IRT分析中,所有题目的infit值均接近或处于可接受范围内,显示题目拟合良好。此外,测验信息曲线显示,测验对中等及以上能力水平的学生有较高的信息量,部分题目在高能力区域的信息贡献较为明显。

第二,高质量的情境材料仍是素养题目开发的关键。正如Tout和Spithill所指出,开发素养测试题目的关键在于选取真实可信且易于学生理解的情境[23]。本研究中,作为情境来源的781篇科普文章最终仅生成4个有效题目,材料利用率仅为5‰。未来,工作重点仍是高质量情境化任务的开发[20,23],应大力拓展材料来源,以丰富的真实材料涵盖学生熟悉的日常生活、社会现象与跨学科场景,从而提升任务的相关性与吸引力。同时,引入检索增强生成技术(retrieval-augmented generation)[31],对情境材料中超出学生知识结构的内容进行识别与筛选,以提升材料筛选效率和题目适配度。

第三,大语言模型生成的初始题目仍需依赖人工优化。本研究证明,大语言模型能够快速生成创造性思维题目的草稿,显著提升命题效率,但生成的题目仍需经过人工筛选与修订。与已有研究结论一致,并非所有模型都能准确生成符合测量目标的题目[7]。尽管目前仍存在局限,但出声思考访谈分析显示,学生在人工优化后的题目中普遍表现出良好的发散性与聚合性思维,表明测验具有较好的内部效度。

第四,综合使用大语言模型技术提升命题质量。未来,应进一步优化提示词工程,探索更系统的任务链设计;采用多智能体协作机制,在篇章映射、材料审查、题目生成与筛选修改等关键环节中实现分工协同,提升命题流程的自动化水平与生成题目的质量。同时,结合不断积累的学生作答数据,探索通过微调模型提升题目生成质量的可行性;引入多模态大语言模型,结合图像生成与情境理解能力,开发更加真实、丰富的情境化测验任务。

参考文献略。